子供の安全性は、特に児童性虐待資料(CSAM)の循環を防ぐことに関して、ハイテク業界で常に重要な懸念事項でした。 Appleがこの問題に対処しようとする試みは、オンデバイスおよびiCloud CSAM検出ツールを通じて、最初に発表されたときに物議を醸すターンを遂げました。

2022年12月にCSAM検出ツールを放棄するというAppleの決定は疑問を投げかけており、Heatイニシアチブと呼ばれる子どもの安全グループがAppleを回答のためにプッシュする最前線にありました。これに応じて、Tech Giantは、CSAM検出計画の放棄について、最も詳細な説明を提供しています。

児童の性的虐待資料は、積極的な解決策を必要とする非常に厄介な問題のままです。 Appleは当初、この有害なコンテンツの広がりに対抗するために、CSAM検出ツールの概念を導入しました。しかし、同社はユーザーのプライバシーとセキュリティに関するかなりの反発と倫理的懸念に直面していました。この論争をきっかけに、熱イニシアチブはAppleの決定に対して強い姿勢を取り、それに対するキャンペーンを組織すると脅した。

熱イニシアチブに対する包括的な対応(経由有線)、Appleのユーザープライバシーと子どもの安全担当ディレクターであるErik Neuenschwanderは、CSAMの検出を放棄する決定は軽視されていないことを強調しました。彼は、消費者の安全性とプライバシーに対する会社のコミットメントを、コミュニケーションの安全性として知られる機能セットへのピボットの背後にある原動力として概説しました。 Neuenschwanderは、CSAMの検出のために暗号化された情報にアクセスしようとすると、さまざまな政府の要求と対立しているAppleのより広範なプライバシーとセキュリティの原則と矛盾すると説明しました。

Appleの応答は、ユーザーのプライバシーとセキュリティの侵害に対する揺るぎない姿勢を強調しました。 Neuenschwanderは、個人的に保存されたiCloudデータの広範なスキャンが潜在的なデータ侵害の新しい脆弱性をもたらすと指摘しました。さらに、それはバルク監視と意図しない結果につながる可能性のある危険な先例を設定し、Appleが賞賛されている基本原則を侵食します。

Neuenschwanderの反応は、CSAMの検出を放棄するというAppleの決定に失望を表明したHeatイニシアチブのリーダーであるSarah Gardnerに直接対処しました。 Gardnerは、提案されたソリューションがAppleをユーザープライバシーのリーダーとして位置づけ、Icloudからかなりの量のCSAMを根絶したと考えていました。彼女のメッセージの中で、彼女は児童の性的虐待と戦うために重要な技術を実施する緊急性を伝えました。

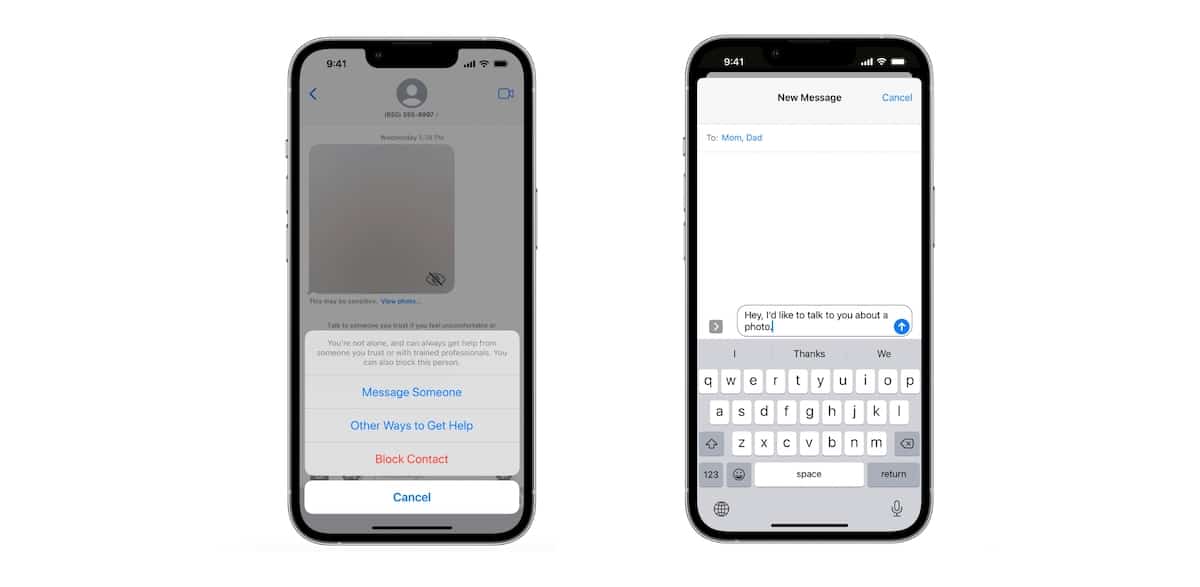

Appleのアプローチは、レポートの処理の仲介者として行動するのではなく、適切なリソースと法執行機関に犠牲者を導くことに焦点を当てています。同社は、サードパーティアプリがユーザーを教育し、犯罪者の報告を促進するために使用できるAPIを開発しています。 Appleは、ユーザーがメッセージから露骨なコンテンツをフィルタリングするのに役立つ通信安全機能も導入しています。この機能は最初は子供のアカウントで利用可能でしたが、iOS 17の大人に拡大する予定であり、将来さらに拡大する計画があります。

関連している:Appleは、メッセージのコミュニケーションの安全性に集中するためにiCloud写真のCSAM検出を殺します

CSAMの検出を進めないというAppleの決定は、ユーザーのプライバシーとセキュリティに対する会社の不屈のコミットメントによって推進されたことに注意することが不可欠です。熱イニシアチブへの対応は、この極めて重要な決定につながった懸念と考慮事項を明確にします。子どもの性的虐待に対処することは重要な問題のままですが、Appleのアプローチは、ユーザーデータの保護とCSAMとの戦いを支援することとのバランスをとることを目指しています。