iCloud写真のCSAM検出の発売を遅らせた後、Appleはついに物議を醸す安全機能のプラグを引き出しました。 Wiredは、ハイテク企業が、新しいCSAM(児童の性的虐待資料)の生成を防ぐために、代わりにメッセージのコミュニケーションの安全性に焦点を当てることを決定したと報告しています。

2021年、Appleはすべてのデバイスの3つの新しい子どもの安全機能を発表し、子供のオンライン安全性を確保し、CSAMの拡散を停止します。メッセージの安全なコミュニケーション、CSAM検出、インテリジェントなSIRIと検索で、危険なオンラインインタラクションのガイダンスを提供します。

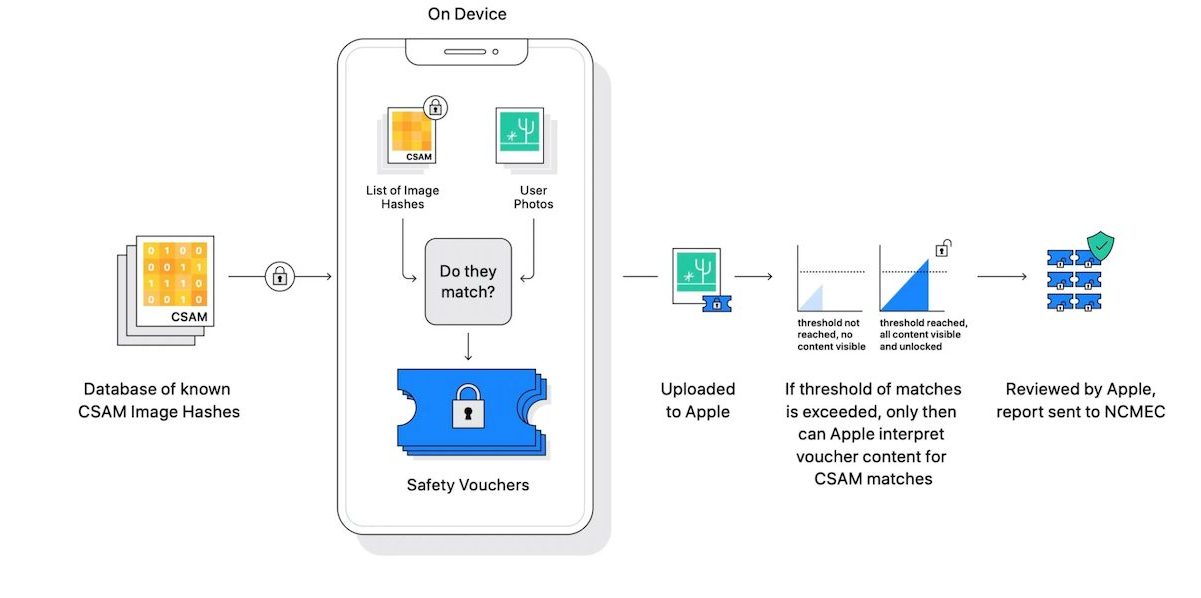

ただし、セキュリティとプライバシーの専門家は、クラウド上のアップロード中にNCMECが提供する既知のハッシュのユーザーの写真をスキャンおよびマッチングするためにハッシュシステムを使用したiCloud写真機能のCSAM検出の潜在的な誤用に関する懸念を直ちに提起しました。現在、iCloud写真のCSAM検出が起動しないことが確認されています。会社は言った:

「昨年提案した児童保護イニシアチブに関するフィードバックを収集するために専門家との広範な協議の後、2021年12月に最初に利用できるコミュニケーション安全機能への投資を深めています。

さらに、以前に提案されていたCSAM検出ツールをiCloud写真用に進めないことにしました。子どもたちは、個人データを組み合わせることなく保護することができます。そして、私たちは政府、児童擁護者、および他の企業と協力して、若者を保護し、プライバシーの権利を維持し、インターネットを子どもたちと私たち全員にとってより安全な場所にします。」

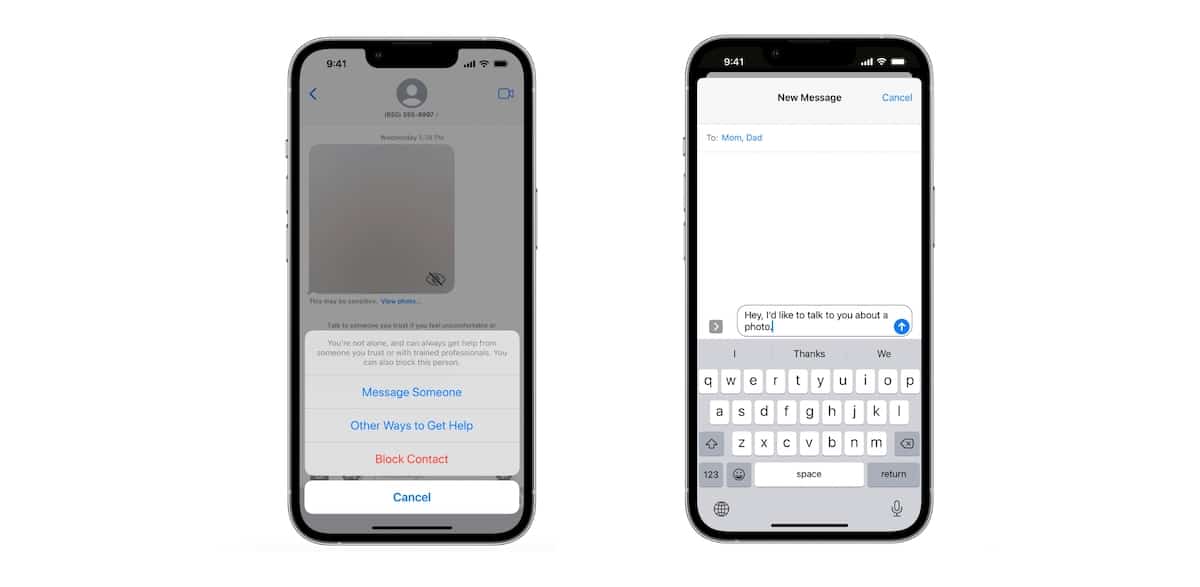

iOS 15.2では、Appleは、若いiPhoneユーザーを明示的なコンテンツから保護するための家族共有計画を持つ保護者または介護者向けに設計されたオプトイン安全機能であるメッセージで通信安全をリリースしました。有効にすると、この機能は、ヌードまたはCSAMのメッセージアプリで送信および受信された画像を分析します。

検出された場合、この機能は画像を曖昧にし、画像がプライベートな部分を表示するように敏感である可能性があるという警告を表示し、画像内の人の許可なしに共有できた可能性があります。また、若い受信者は、それが彼らのせいではないこと、そして彼らが「大人」とメッセージを共有することで経験について信頼できる人に話すことができることを通知されます。

より多くの投資により、ハイテク企業は、通信安全が有効になったときに、メッセージまたはサードパーティのメッセージングアプリを介して共有されるビデオにNudityまたはCSAMの検出を追加することに取り組んでいます。

提案された読み:Appleは韓国、ブラジルなどの「メッセージのコミュニケーションの安全」をリリースします

「潜在的な児童搾取は、親に安全でないコミュニケーションから子どもを保護するためのオプトインツールを提供することにより、それが起こる前に中断することができます」と同社は声明で述べました。 「Appleは、個人的なコミュニケーションとデータストレージの独自のプライバシーニーズに対処しながら、児童の性的虐待資料と戦い、子どもを保護するための革新的なプライバシーを提供するソリューションの開発に専念しています。」

さらに、ハイテク大手言ったまた、CSAMの拡散を止めるために搾取的なコンテンツを簡単に報告できるように、子どもの安全の専門家と協力し続けること。反セクシュアル暴力組織Rainn氏は次のように述べています。

材料が子供のデバイスによって送信される前にCSAMをスキャンすることは、これらのツールの1つであり、問題の範囲を制限するのに役立ちます。

現在、メッセージのコミュニケーションの安全性は、米国、カナダ、英国、オーストラリア、ニュージーランドで入手できます。

続きを読む:

- iOS 15.2のメッセージで通信安全を簡単にオンにする方法

- 子どもの安全「メッセージ分析システム」は、メッセージのエンドツーエンドの暗号化を破ることはありません、とAppleは言います

- GoogleによるCSAMハッシュエラーは、親をトラブルに巻き込み、AppleのCSAM検出についてさらに疑問を投げかけます

- デジタル権利団体EFF AppleにCSAM計画を完全に放棄するよう促す

- Appleは、iCloudの写真ではなく、icloudメールをスキャンすることを確認していますが、まだ