インターネットを必要とせずにMacでChatGptのようなものをローカルに実行できるかどうか疑問に思ったことはありませんか?ほんの少しのセットアップで、実際にできます。それも無料です。チャットを非公開にしたい場合でも、AIへのオフラインにアクセスしたい場合でも、Macでローカルで強力な大手言語モデルを実行する方法は次のとおりです。

#image_title

飛び込んでセットアップをチェックする前に、必要なものは次のとおりです。

MacでLLMをローカルに実行する方法

呼ばれる無料ツールを使用しますオラマ、ほんの数件のコマンドでLLMSをローカルにダウンロードして実行できます。開始方法は次のとおりです。

ステップ1:HomeBrew(すでにインストールされている場合はスキップ)をインストールする

HomeBrewは、ターミナルアプリからアプリをインストールするのに役立つMacOSのパッケージマネージャーです。すでにMacにHomebrewをインストールしている場合は、この手順をスキップできます。しかし、そうでない場合は、これをインストールする方法は次のとおりです。

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"brew doctor

「システムが醸造の準備ができている」と表示されている場合は、行ってもいいです。

問題が発生している場合や、より詳細なステップバイステッププロセスが必要な場合は、MacにHomebrewをインストールする方法に関するガイドをご覧ください。

ステップ2:オラマをインストールして実行します

Homebrewがインストールされ、Macで使用できるようになったので、Ollamaをインストールしましょう。

brew install ollamaollama serve

このウィンドウを開いたままにしておくか、最小限に抑えます。このコマンドは、オラマをバックグラウンドで実行し続けます。

または、ダウンロードしてくださいOllamaアプリ通常のMacアプリのようにインストールします。完了したら、アプリを開き、バックグラウンドで実行し続けます。

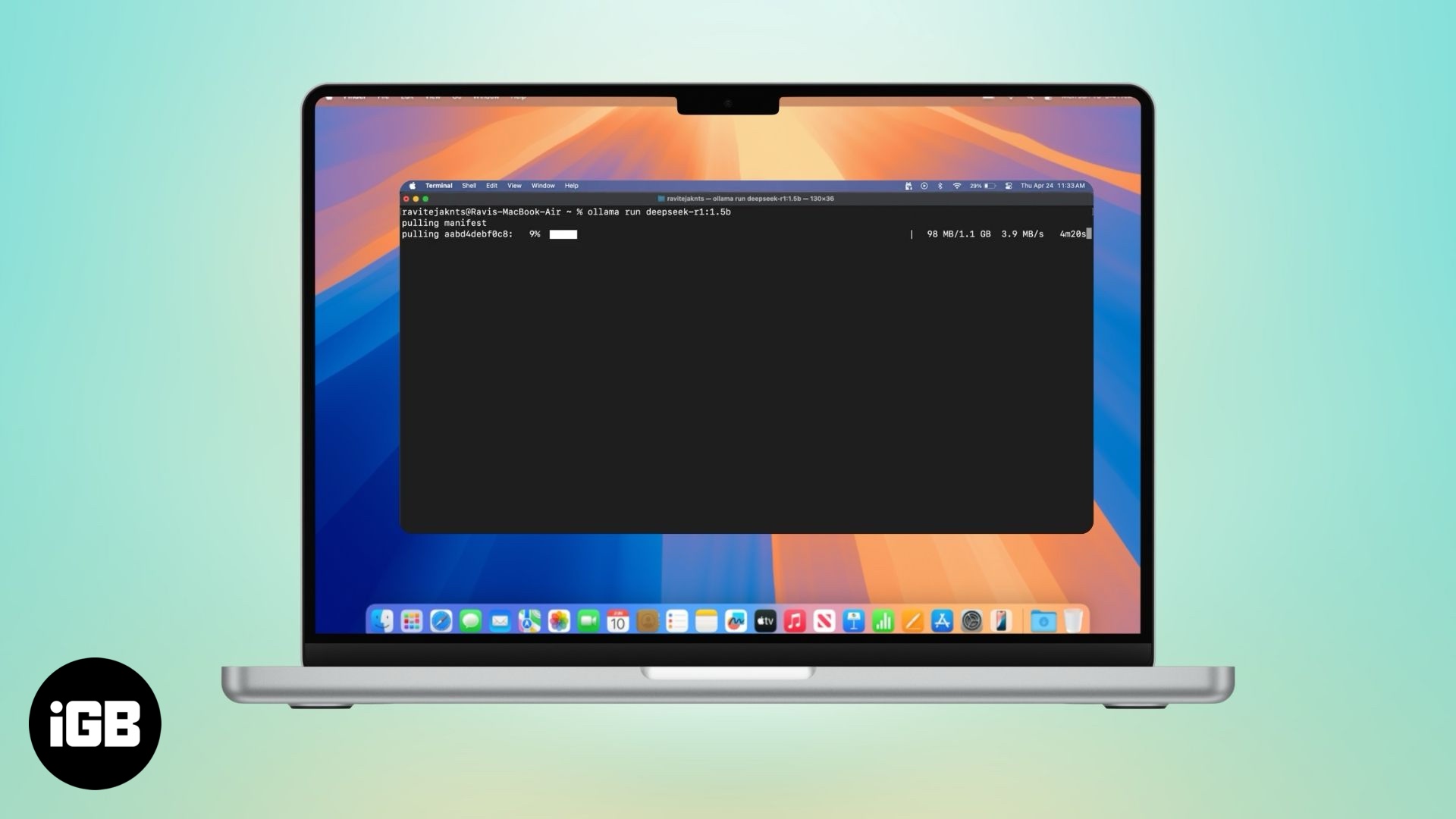

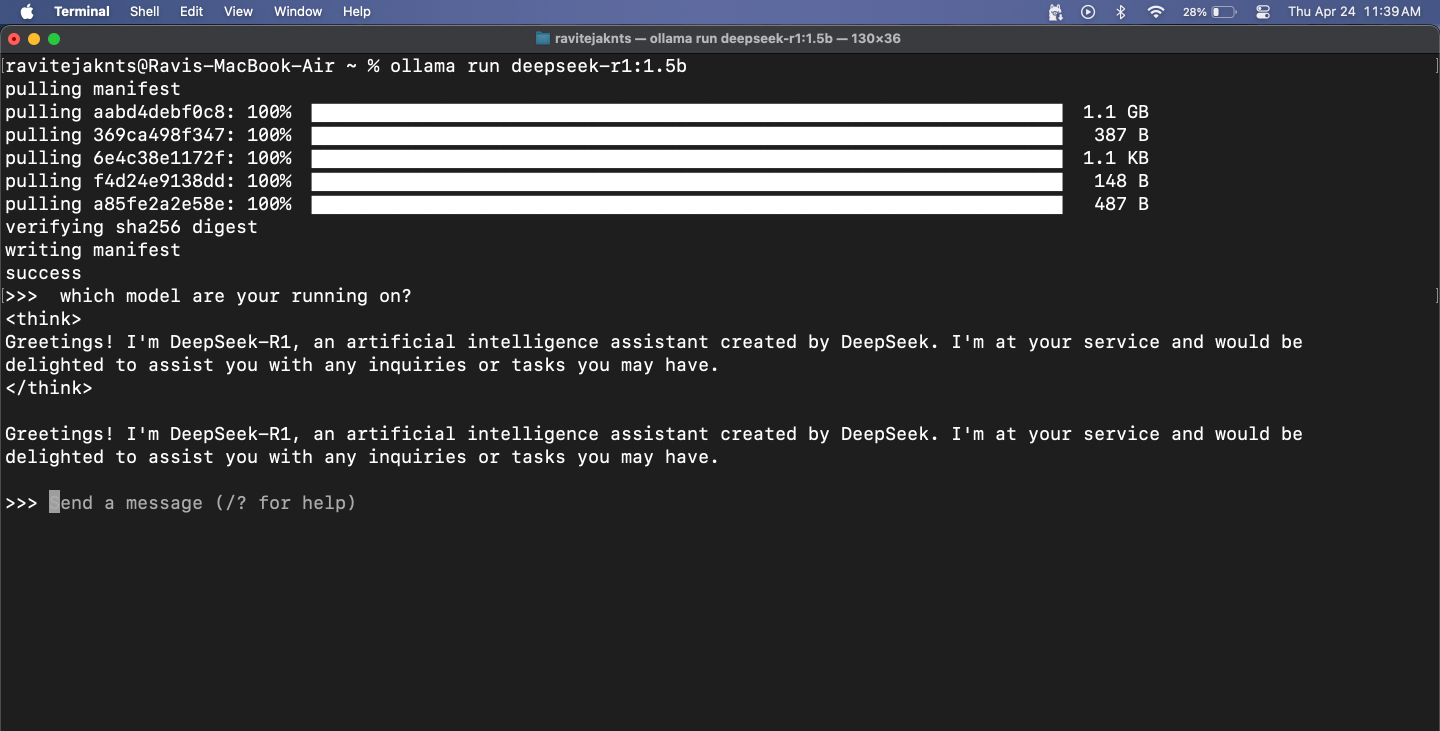

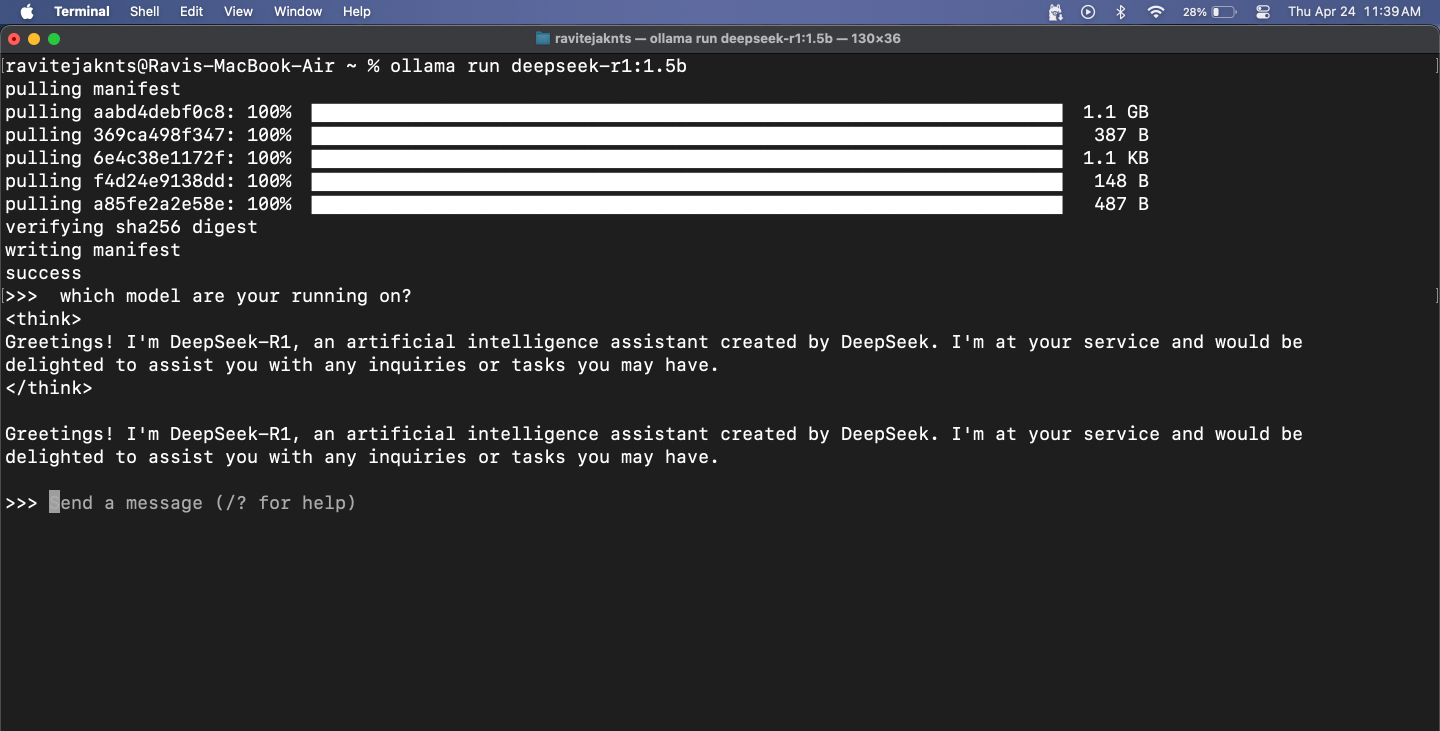

ステップ3:モデルをダウンロードして実行します

Ollamaは、Deepseek、Meta's Llama、Mistral、Gemmaなどの人気のあるLLMにアクセスできます。選択して実行する方法は次のとおりです。

大きなモデルを選択する場合は、いくつかの遅れを期待してください。結局のところ、モデル全体がMacBookでローカルに実行されています。小規模なモデルはより速く反応しますが、特に数学と論理関連のタスクについては、正確さに闘うことができます。また、これらのモデルにはインターネットアクセスがないため、リアルタイムの情報を取得できないことを忘れないでください。

とはいえ、文法をチェックしたり、メールを書いたり、アイデアをブレインストーミングするなど、それらは見事に働きます。 Web UIセットアップを備えたMacBookでDeepSeek-R1を広範囲に使用しました。これにより、画像をアップロードしてコードスニペットを貼り付けることができます。その答え、特にコーディングスキルは、ChatGPTやDeepSeek 671Bなどの最高層モデルほどシャープではありませんが、インターネットを必要とせずにほとんどの日常のタスクを実行しています。

ステップ4:ターミナルでモデルとチャットします

モデルが実行されたら、メッセージを入力してヒットするだけです戻る。モデルはすぐに応答します。

セッションを終了するには、押しますコントロール+dキーボードに。もう一度チャットを始めたいときは、同じものを使用してくださいollama run [model-name]指示。モデルはすでにダウンロードされているため、すぐに起動します。

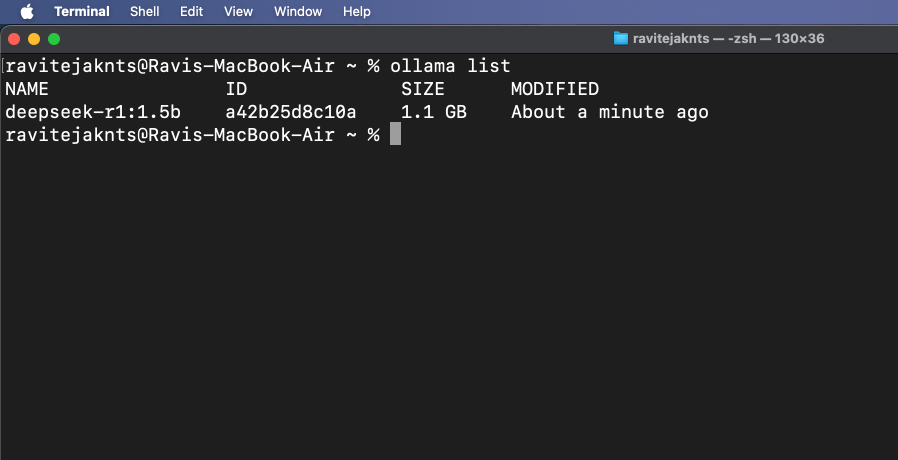

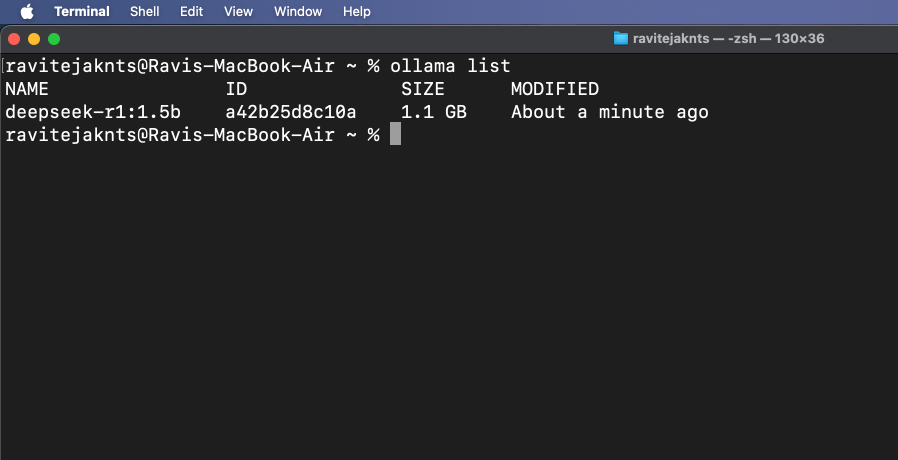

ステップ5:インストールされたモデルの表示と管理

現在ダウンロードされているモデルを確認するには、実行してください。

ollama list

もう必要ないモデルを削除するには、以下を使用してください。

ollama rm [model-name]ボーナス:Web上にUIを使用してOllamaを使用します

Ollamaはターミナルで実行されますが、https:// localhost:11434でローカルAPIサービスも開始し、チャットボットを使用するのと同じように、モデルとの視覚的な相互作用のためにWebインターフェイスに接続できます。これに人気のあるオプションの1つは、Ollamaのコア機能の上にユーザーフレンドリーなインターフェイスを提供するOpen WebUIです。セットアップ方法を見てみましょう。

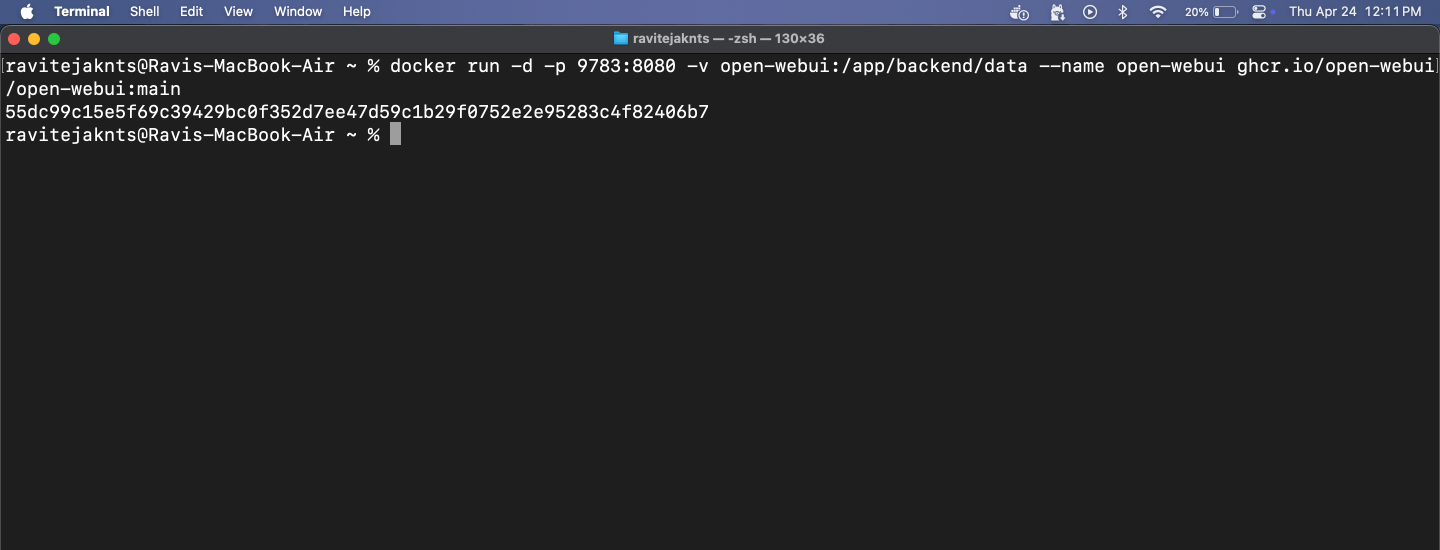

ステップ1:Dockerをインストールします

Dockerは、プログラムとそのすべての重要な要素をポータブルコンテナにパッケージ化できるツールであるため、あらゆるデバイスで簡単に実行できます。 AIモデルのWebベースのチャットインターフェイスを開くために使用します。

Macがまだ持っていない場合は、次の手順に従ってDockerをインストールします。

docker --version

コマンドがバージョン番号を返す場合、DockerがMacにインストールされていることを意味します。

ステップ2:Open WebUI画像を引っ張ります

Open WebUIは、ブラウザにチャットウィンドウを提供するシンプルなツールです。画像を引っ張るということは、それを実行するのに必要なファイルをダウンロードすることを意味します。

これを行うには、に進みますターミナルアプリとタイプ:

docker pull ghcr.io/open-webui/open-webui:mainこれにより、インターフェイスに必要なファイルがダウンロードされます。

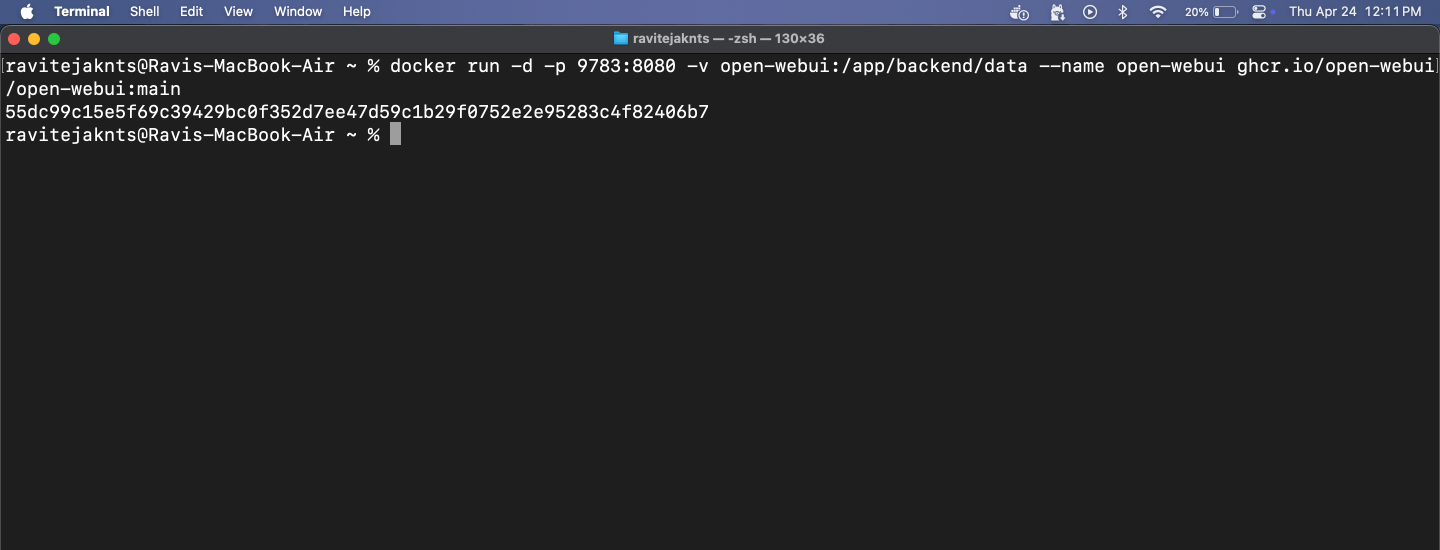

ステップ3:Dockerコンテナを実行し、WebUIを開きます

さて、Dockerを使用してOpen WebUIを実行する時が来ました。 AIとチャットできるクリーンなインターフェイスが表示されます。ターミナルは必要ありません。これがあなたがする必要があることです:

docker run -d -p 9783:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

https://localhost:9783/

関連している:Windows11で管理者としてファイルエクスプローラーを実行する方法

ここから、クリーンでユーザーフレンドリーなブラウザインターフェイスでインストールされているモデルとチャットできます。この手順はオプションですが、端末を使用せずにスムーズなチャットエクスペリエンスを提供します。

Mac、AI:サーバーなし、文字列なし

それでおしまい!ほんの数ステップで、Macを設定して、強力なAIモデルを完全にオフラインで実行することになりました。セットアップ後にアカウントもクラウドもインターネットも必要ありません。プライベートな会話、ローカルテキストの生成、またはLLMSを試したい場合でも、Ollamaは開発者でなくても簡単でアクセスしやすくします。試してみてください!

これらの役立つガイドもチェックしてください: